Motori di ricerca con intelligenza artificiale: come cambiano le strategie digitali

L’intelligenza artificiale non è più una novità: è diventata la spina dorsale della SEO contemporanea. Nel 2025 non si parla più soltanto di “algoritmi intelligenti”, ma di sistemi capaci di interpretare, prevedere e sintetizzare le intenzioni degli utenti, ridisegnando il modo in cui i contenuti vengono mostrati nei risultati di ricerca.

Fenomeni come gli AI Overview, l’aumento delle ricerche zero-click e la progressiva riduzione dei CTR nelle prime posizioni mostrano un panorama in rapido mutamento. I motori di ricerca non si limitano più a indicizzare pagine: analizzano contesto, linguaggio, immagini e comportamento dell’utente per restituire risposte sempre più “umane”.

Questo solleva una domanda cruciale, siamo davanti a una rivoluzione che stravolge vent’anni di SEO oppure a una naturale evoluzione dei motori di ricerca?

L’AI può ridefinire la SERP, ma il gioco rimane aperto a chi sa leggere i dati in tempo reale e costruire strategie adattive, basate su analisi continue e approcci conversazionali.

La ricerca non è più solo testuale: è multimodale, visiva e vocale. In questo ecosistema che corre veloce, l’adattamento non è solo una necessità, ma un’occasione per riscrivere e comprendere meglio le nuove regole della visibilità digitale.

Il modo in cui cerchiamo e troviamo informazioni sta attraversando un’evoluzione profonda. I motori di ricerca non si limitano più a elencare link: stanno diventando piattaforme cognitive capaci di comprendere, sintetizzare e rispondere.

L’intelligenza artificiale non sostituisce la ricerca, ma ne riscrive la grammatica, le query diventano conversazioni, le SERP si trasformano in contesti informativi, e la posizione organica lascia spazio a una nuova forma di visibilità contestuale, dove conta essere citati, interpretati o integrati nei risultati generativi.

Anche il concetto stesso di ottimizzazione sta cambiando:

- le parole chiave lasciano il posto all’intento di ricerca e al contesto d’uso;

- i contenuti sintetici e strutturati, leggibili dalle AI e utili per gli utenti, diventano il formato più efficace;

- l’AI diventa un co-autore operativo, capace di supportare keyword research, test e analisi, senza sostituire la supervisione umana;

- la SEO si estende oltre Google, dando vita a una strategia di “Search Engine Everywhere”, dove anche chatbot, social e piattaforme AI partecipano al percorso informativo dell’utente.

In questo scenario in continua trasformazione, la vera sfida non è più solo “posizionarsi”, ma rimanere comprensibili, citabili e rilevanti per sistemi di ricerca che pensano e apprendono come intelligenze artificiali.

Come funziona la ricerca tradizionale

Per oltre vent’anni, i motori di ricerca hanno seguito uno schema piuttosto lineare, fondato su un principio semplice: l’abbinamento delle parole chiave. Quando un utente digitava un termine, l’algoritmo lo confrontava con miliardi di pagine indicizzate e restituiva i risultati ritenuti più pertinenti. L’intero sistema ruotava intorno a tre pilastri fondamentali.

Algoritmi basati su keyword

Le parole chiave erano il cuore dei motori di ricerca tradizionali. Ogni parola o combinazione di termini possedeva un peso e una funzione precisa.

Le ottimizzazioni SEO si concentravano sull’uso strategico delle keyword nei title, nei meta tag, nei testi e nei link interni, così da favorire la corrispondenza diretta con la query dell’utente.

Gli strumenti di pianificazione, come i keyword planner, fornivano volumi di ricerca, ma non informazioni sull’intento dell’utente.

Come rilevato da Yuniarthe (2017), l’intelligenza artificiale ha poi cambiato questo paradigma: gli strumenti AI sono in grado di analizzare in pochi secondi grandi quantità di dati, identificando parole chiave a coda lunga e priorità basate non solo sul traffico, ma anche sul potenziale di conversione.

SEO on-page e off-page

Il secondo pilastro era la struttura. Sul piano on-page, contavano elementi come l’organizzazione dei titoli (H1, H2…), la leggibilità del codice, la velocità del sito e la compatibilità mobile. Sul piano off-page, invece, Google valutava i link in entrata e le citazioni da altri siti come segnali di autorevolezza. La combinazione di questi fattori determinava la “reputazione” di una pagina, concetto formalizzato nel celebre PageRank.

La SERP classica

Il risultato di questo processo era la SERP lineare, un elenco gerarchico di link blu ordinati per pertinenza.

Col tempo si sono aggiunti snippet, immagini, mappe e box locali, ma lo scopo restava invariato: portare l’utente a cliccare su un sito esterno.

In questo modello, prevedibile e meritocratico, chi lavorava bene su keyword e autorevolezza poteva scalare le posizioni.

Tuttavia, il limite di questa logica era evidente: tutto dipendeva dalla capacità del motore di “capire” le parole, non il significato.

Con l’introduzione di algoritmi basati sull’intelligenza artificiale la ricerca ha iniziato a spostarsi da una corrispondenza letterale a una comprensione semantica.

I motori non si limitano più a confrontare termini, ma cercano di interpretare il contesto, l’intenzione e la relazione tra le parole, come confermato dagli studi successivi (Rathnayaka et al., 2024).

In sintesi, la ricerca tradizionale era un sistema solido ma rigido, basato su regole chiare e unidirezionali. L’era dell’intelligenza artificiale ha reso tutto più fluido: i motori apprendono, collegano, anticipano. La linea retta che univa query e risultato è diventata una rete dinamica di significati.

L’impatto dell’AI sulla ricerca

Per anni i motori di ricerca hanno funzionato secondo la logica del grande indice di pagine, basato sulla corrispondenza delle parole chiave. Oggi, con l’arrivo dell’intelligenza artificiale, questa logica è stata trasformata in un sistema adattivo e cognitivo, in grado di interpretare e generare contenuti in modo sempre più vicino al linguaggio umano.

I moderni motori di ricerca non si limitano a restituire un elenco di link: diventano assistenti intelligenti, capaci di comprendere l’intento dell’utente, elaborare informazioni multimodali (testo, immagini, voce) e produrre risposte personalizzate.

Come osservato da Yuniarthe (2017), l’integrazione di sistemi AI come RankBrain e BERT consente ai motori di interpretare il significato dietro ogni query, analizzando struttura grammaticale, relazioni semantiche e persino comportamento di ricerca individuale.

Questo processo viene definito interpretazione contestuale dell’utente: un’evoluzione che permette di fornire risultati pertinenti anche di fronte a domande complesse o ambigue.

Il passaggio dalla ricerca “statica” alla ricerca “intelligente” comporta tre cambiamenti chiave:

- Dalla keyword all’intento.

Le parole chiave non sono più l’unico riferimento: oggi ciò che conta è perché l’utente formula una certa domanda.

Gli algoritmi di AI interpretano l’intenzione dietro una frase, considerando il contesto e il comportamento pregresso, un approccio che favorisce la comprensione semantica e riduce l’ambiguità. - Dal testo alla multimodalità.

Con l’evoluzione dei modelli di Google, da BERT a MUM, fino a Gemini, la ricerca è diventata multimodale: integra parole, immagini, video, suoni e lingue diverse per rispondere a query articolate. MUM, ad esempio, è in grado di collegare contenuti testuali e visivi in più lingue, mentre Gemini rappresenta un modello nativamente multimodale, capace di fondere in un unico flusso testo, immagini, audio e video. - Dall’indicizzazione alla sintesi.

Il motore di ricerca non si limita a trovare informazioni: le sintetizza.

È il principio che sta alla base degli AI Overview, ovvero panoramiche generative che riassumono le informazioni raccolte dall’indice, offrendo all’utente risposte immediate, spesso senza la necessità di cliccare su un link esterno.

In questo scenario, i brand si trovano davanti a una sfida inedita:

come farsi trovare, riconoscere e citare in un motore di ricerca che non è più un semplice indice? La risposta, come mostrano le ricerche recenti, risiede nella qualità dei contenuti, nella loro struttura semantica e nella capacità di rappresentare in modo coerente l’esperienza e l’affidabilità del brand.

Dalle keyword all’intento di ricerca

Uno dei cambiamenti più evidenti introdotti dall’intelligenza artificiale nella SEO riguarda il modo in cui vengono riconosciute e interpretate le parole chiave.

Fino a pochi anni fa, la ricerca ruotava intorno a un principio: le keyword, che rappresentavano coordinate esatte da inserire nei testi, nei meta tag e nei titoli per far “capire” al motore di cosa trattasse una pagina. Oggi, questa relazione diretta si sta progressivamente trasformando in un dialogo semantico.

Gli studi di Yuniarthe (2017) hanno mostrato come gli strumenti basati su AI possano analizzare enormi quantità di dati in pochi secondi, individuando non solo le parole chiave più popolari ma anche quelle a coda lunga, in grado di intercettare intenzioni di ricerca più specifiche. Parallelamente, gli algoritmi di ricerca hanno spostato il focus dalla semplice corrispondenza testuale all’analisi del contesto linguistico e comportamentale.

Non è più tanto importante che una pagina contenga le stesse parole dell’utente, quanto che sappia rispondere all’intento che quelle parole sottintendono.

L’evoluzione di questa logica si riflette nel modo in cui le AI analizzano i contenuti:

le reti semantiche costruite da modelli come BERT mostrano relazioni molto dense tra pochi concetti principali, mentre quelle generate da ChatGPT appaiono più bilanciate, con connessioni più fluide e meno frammentate (Rathnayaka et al., 2024).

Dal punto di vista SEO, questo significa che la coesione tra le parole chiave è oggi tanto importante quanto la loro presenza. Un contenuto ricco ma disordinato rischia di essere interpretato come “rumore”, mentre uno troppo chiuso su pochi termini può risultare povero di segnali contestuali.

In mezzo, si delinea una zona di equilibrio: contenuti in cui le keyword non sono semplici etichette, ma punti di connessione tra argomenti affini, in grado di disegnare una rete di significati coerente e leggibile sia dai motori che dalle persone.

L’obiettivo non è più “inserire parole”, ma capire il linguaggio con cui gli utenti esprimono un bisogno e anticipare le modalità con cui un sistema AI lo interpreterà.

Si tratta di un processo in evoluzione, non di una regola consolidata, ma che sembra orientare il futuro dell’ottimizzazione verso una SEO più cognitiva e meno meccanica.

Riconoscimento delle immagini e ricerca visiva

Un altro fronte di trasformazione della SEO è rappresentato dalla ricerca visiva, un campo che si sta espandendo rapidamente grazie ai progressi nel riconoscimento delle immagini supportato dall’intelligenza artificiale.

Come osservato da Yuniarthe (2017), l’AI ha cambiato profondamente il modo in cui i motori di ricerca analizzano, interpretano e indicizzano i contenuti visivi. Non si tratta più soltanto di leggere i metadati o il testo alternativo associato a un’immagine. Gli algoritmi di machine learning sono oggi in grado di comprendere il contenuto visivo stesso, riconoscendo oggetti, ambienti, volti, contesti semantici e semiotici.

In termini pratici, ciò significa che un motore di ricerca può “vedere” e comprendere un’immagine in modo simile a come lo farebbe un utente umano. Questa capacità apre nuove opportunità, in particolare per i settori dove l’aspetto visivo è cruciale, come l’e-commerce, la moda, l’arredamento o il turismo. Gli utenti possono oggi cercare prodotti direttamente caricando una foto o inquadrando un oggetto reale tramite strumenti come Google Lens.

La ricerca visiva rappresenta quindi una nuova modalità di interazione, in cui la query non è più scritta ma vista. Questo passaggio implica un diverso tipo di ottimizzazione SEO, dove l’obiettivo non è soltanto descrivere le immagini, ma renderle interpretabili dalle AI e dai motori di ricerca.

L’uso coerente di testi alternativi (alt text), nomi file significativi, dati strutturati e contesto semantico visivo resta fondamentale, ma non basta. Diventa importante che le immagini siano coerenti con il contenuto testuale e inserite in pagine che ne chiariscano il significato d’uso.

L’introduzione della ricerca multimodale, menzionata anche nei report più recenti, va nella stessa direzione: combinare linguaggio naturale, voce e immagini in un’unica esperienza di ricerca integrata. In questa prospettiva, la SEO non può più essere considerata un aspetto tecnico marginale, ma un elemento strategico di accessibilità e interpretazione dei contenuti.

Non è ancora chiaro fino a che punto il riconoscimento visivo influenzerà i ranking in modo diretto, ma la tendenza sembra orientarsi verso una progressiva integrazione.

In altre parole, la visibilità non dipenderà solo dalle parole, ma anche dalla capacità di essere compresi visivamente.

Ricerca vocale e linguaggio naturale

Parallelamente alla ricerca visiva, anche la ricerca vocale ha modificato profondamente il modo in cui gli utenti interagiscono con i motori.

Con la diffusione di assistenti vocali come Siri, Alexa e Google Assistant, la ricerca si è spostata da input testuali brevi a domande conversazionali, formulate in linguaggio naturale.

Come evidenziato da Yuniarthe (2017), gli algoritmi di intelligenza artificiale vengono addestrati per comprendere le sfumature del linguaggio umano: il tono, la struttura grammaticale, i sinonimi e il contesto. In questo modo, i motori possono interpretare query complesse o imprecise, restituendo risultati più coerenti con l’intenzione reale dell’utente.

Questo tipo di interazione si fonda su una logica diversa rispetto alla SEO tradizionale.

Le ricerche vocali, infatti, sono spesso più lunghe, naturali e discorsive, e contengono parole chiave a coda lunga (long-tail keywords) o domande intere come “qual è il miglior ristorante vicino a me?” o “come posso migliorare il posizionamento del mio sito?”.

Di conseguenza, le strategie SEO devono orientarsi verso contenuti più colloquiali, in grado di rispondere direttamente a questi quesiti.

Nel contesto della SEO, questo cambiamento implica che le pagine più efficaci siano quelle che anticipano le domande e forniscono risposte concise, chiare e verificabili.

In parallelo, la ricerca vocale si intreccia sempre più con la personalizzazione: i risultati dipendono non solo dalle parole, ma anche dalla posizione geografica, dalle preferenze personali e dalle abitudini di ricerca precedenti.

Questo porta a una SEO più dinamica, dove l’obiettivo non è soltanto comparire, ma apparire nel modo giusto, per la persona giusta e nel momento giusto.

L’evoluzione verso la ricerca basata sulla lingua naturale non si è ancora stabilizzata: è un terreno in movimento, dove le aziende e i professionisti stanno sperimentando soluzioni diverse per adattare tono, formato e struttura dei contenuti.

Ciò che emerge, tuttavia, è una tendenza condivisa: scrivere per le persone che parlano, non per i motori che leggono.

Dall’analisi AI alla costruzione di reti semantiche

Uno degli ambiti più interessanti dell’applicazione dell’intelligenza artificiale alla SEO riguarda la possibilità di analizzare e rappresentare le connessioni semantiche tra le parole chiave.

Questo approccio, sperimentato in studi recenti come quello di Rathnayaka et al. (2024), mostra come modelli linguistici differenti generino reti concettuali con caratteristiche proprie, influenzando di fatto il modo in cui i contenuti vengono interpretati dai motori di ricerca.

Nel loro esperimento, gli autori hanno confrontato tre diversi modelli:

- una rete costruita manualmente da autori umani,

- una rete generata da BERT,

- e una rete creata da ChatGPT.

Ogni rete era composta da nodi (le parole chiave), archi (le connessioni tra parole che co-occorrono almeno due volte) e componenti (gruppi di parole isolati).

Attraverso queste strutture, è stato possibile osservare come ogni modello organizzasse la conoscenza in modo diverso, con implicazioni interessanti anche per la SEO.

- Rete dell’autore: ampia ma dispersa

La rete costruita dagli autori conteneva 531 parole chiave e oltre 1100 connessioni, ma con una densità piuttosto bassa (0,008).

Questo significa che il contenuto copriva un ampio ventaglio di argomenti, ma con legami deboli tra i concetti.

Dal punto di vista SEO, una struttura di questo tipo può corrispondere a un sito o a un testo che tratta molti temi senza un filo conduttore chiaro, rendendo più difficile per Google comprendere la gerarchia e la pertinenza dei concetti.

Un contenuto ampio ma poco coeso può risultare informativo, ma rischia di disperdere la rilevanza semantica.

- Rete BERT: piccola, frammentata ma densa

La rete prodotta da BERT risultava invece più compatta: 176 parole chiave e 216 connessioni, con una densità di 0,014.

Ciò suggerisce una concentrazione su pochi concetti centrali, collegati da relazioni più strette ma distribuiti in molti piccoli gruppi isolati.

In termini SEO, questa configurazione potrebbe riflettere testi molto specifici, ben legati semanticamente all’interno di un tema, ma con sezioni che non comunicano tra loro.

È una forma di precisione utile per il posizionamento su ricerche di nicchia, ma che può ridurre la coerenza globale di un sito o di un argomento complesso.

- Rete ChatGPT: equilibrio e fluidità

La rete generata da ChatGPT rappresentava una via intermedia, con 328 parole chiave, 647 connessioni e una densità di 0,012, oltre a un numero inferiore di componenti (11).

Ciò si traduce in una mappa concettuale più organica e connessa, dove i temi principali dialogano tra loro e il flusso semantico appare più naturale.

Da un punto di vista SEO, questa struttura risulta vantaggiosa: i contenuti che presentano collegamenti logici e tematici ben distribuiti favoriscono sia la comprensione da parte dei motori sia la leggibilità per gli utenti.

Inserendo nel modello dello studio anche la costruzione delle reti semantiche attuata da Gemini, possiamo analizzarne le peculiarità.

- Rete GEMINI: multimodale e contestuale

La rete GEMINI è definita “a strati” perché integra diversi tipi di informazioni, testo, immagini, audio e video, in un unico spazio di rappresentazione.Questo significa che un concetto non viene più espresso e collegato solo da parole, ma anche da elementi visivi o sonori che partecipano alla costruzione del significato. In questo modo, la rete non è più un semplice grafo di parole, ma una rete multimodale di concetti, dove ogni nodo può essere un testo, un’immagine, un suono o una scena video. Ciò genera ponti cross-modali, cioè connessioni che uniscono elementi provenienti da canali diversi. Questo può ridurre la frammentazione (tipica della rete BERT) e la dispersione (tipica della rete dell’autore), avvicinandosi e in alcuni casi superando, l’equilibrio osservato nella rete ChatGPT.

Implicazioni per la SEO

L’analisi di Rathnayaka e colleghi suggerisce che la fluidità e la coesione semantica sono elementi chiave per la visibilità. I motori di ricerca e i loro algoritmi AI tendono a interpretare meglio i contenuti che mostrano relazioni chiare tra i concetti, evitando sia la dispersione (reti troppo sparse) sia l’isolamento (reti troppo frammentate).

In pratica:

- Un contenuto dispersivo rischia di non essere compreso appieno nei suoi legami logici.

- Un contenuto troppo settoriale può essere preciso ma perdere la capacità di connettere i temi correlati.

- Un contenuto ben interconnesso, invece, appare più coerente e utile sia per le AI che per gli utenti.

Questa osservazione trova riscontro anche nei principi SEO: la coesione tematica, la struttura logica interna e l’uso di link interni strategici sono oggi considerati segnali di qualità, perché contribuiscono a creare reti di significato che i motori sanno riconoscere e valorizzare.

In definitiva, pur in un contesto ancora in evoluzione, la capacità di organizzare i concetti in modo relazionale sembra diventare una delle competenze centrali della SEO moderna. Non basta più ottimizzare singole parole chiave: serve costruire architetture di senso, in cui ogni termine sia un nodo di una rete coerente e navigabile.

Sistemi SEO adattivi e apprendimento continuo

Nel panorama attuale, caratterizzato da aggiornamenti sempre più frequenti degli algoritmi di ricerca, l’approccio statico alla SEO, fatto di audit periodici e modifiche sporadiche, mostra tutti i suoi limiti. La complessità del Search moderno richiede sistemi in grado di reagire e adattarsi in tempo reale, modellando strategie dinamiche in base ai segnali dei motori, ai comportamenti degli utenti e alle variazioni del contesto.

Lo studio di Kolèchkina e Orzhynsky (2024) offre una prospettiva interessante: i sistemi SEO adattivi possono ridurre in modo significativo l’impatto negativo dei cambiamenti algoritmici, come quelli introdotti da aggiornamenti quali SGE (Search Generative Experience) o Helpful Content Update, che tra il 2023 e il 2025 hanno causato cali di traffico anche del 50% per molti siti.

Algoritmi, metriche e apprendimento automatico

Un sistema SEO di nuova generazione si basa su monitoraggio continuo e analisi predittiva. Le metriche fondamentali restano il CTR, il tempo medio sulla pagina, il bounce rate, le conversioni e i segnali sociali, ma vengono interpretate tramite machine learning e analisi basata sugli eventi. In altre parole, il sistema non si limita a registrare i dati, ma apprende dal loro andamento per proporre correzioni automatiche e priorità operative.

Tra i modelli più efficaci vengono citati i classificatori e gli algoritmi di clustering, che raggruppano contenuti simili e individuano pattern di successo o criticità.

Questo tipo di approccio consente di correggere dinamicamente parametri SEO (come meta tag, link interni o keyword focus) senza compromettere la stabilità del ranking.

SEO a sprint

Questo modello riflette un approccio che si sta diffondendo anche nella pratica professionale: la SEO a sprint. Come riportato da Search Engine Journal (2024), gli sprint SEO consistono in cicli brevi e mirati, ad esempio di quattro settimane, con obiettivi specifici come:

- ottimizzazione dei contenuti,

- correzione tecnica,

- miglioramento dei collegamenti interni,

- creazione di nuove sezioni o contenuti autorevoli.

Ogni sprint viene poi seguito da una fase di analisi, feedback e correzione. In un contesto in continua evoluzione, questa logica iterativa permette di sperimentare, misurare e ottimizzare in tempi rapidi, riducendo la dipendenza da grandi revisioni periodiche.

Sicurezza e resilienza del sistema

Kolèchkina e Orzhynsky evidenziano anche un aspetto spesso sottovalutato: la sicurezza dei sistemi SEO.

Oltre alle performance, un sito deve proteggersi da minacce che possono compromettere la visibilità o la fiducia del motore di ricerca.

Tra le implementazioni consigliate figurano:

- HTTPS e DNSSEC per garantire integrità e cifratura dei dati;

- CAPTCHA e WAF (Web Application Firewall) per difendersi da spam, attacchi bot e SQL injection;

- protezione dei metadati e del file robots.txt per evitare manipolazioni esterne.

Un’infrastruttura sicura comunica ai motori di ricerca un segnale di affidabilità tecnica, che si traduce in una maggiore stabilità del ranking nel tempo.

Ai Overview e ricerche zero-click

Negli ultimi mesi, uno dei cambiamenti più discussi nel mondo della SEO riguarda l’introduzione delle AI Overview, ovvero i box generativi che Google mostra in cima alla SERP per offrire risposte sintetiche e contestuali alle query degli utenti.

È un’evoluzione che sposta l’attenzione dalla ricerca di link alla ricerca di risposte: il motore non si limita più a indicare dove trovare l’informazione, ma la fornisce direttamente.

Per comprendere la portata del fenomeno, basta considerare che circa il 60% delle ricerche globali non porta più ad alcun clic esterno.

L’utente trova già ciò che cerca all’interno della SERP, nei box informativi, negli snippet o, sempre più spesso, nelle panoramiche AI.

Questa dinamica è ciò che viene comunemente definito come zero-click search.

L’espansione delle Ai Overview

Le stime sulla diffusione delle AI Overview variano a seconda della metodologia, ma la tendenza è chiara: la loro presenza cresce rapidamente.

Secondo i dati di BrightEdge (2024), circa il 15% delle ricerche negli Stati Uniti mostra già un box generativo. SE Ranking osserva che la percentuale aumenta in settori verticali come salute, tecnologia e finanza, dove gli utenti cercano risposte chiare e attendibili. Lo studio Semrush, basato su milioni di query, colloca invece la diffusione tra il 6% e il 13%, con un trend in crescita costante trimestre dopo trimestre.

Queste differenze numeriche non modificano la sostanza del fenomeno: l’AI Overview sta diventando un elemento strutturale della SERP. Google non si limita più a organizzare le pagine, ma comincia a rielaborare i contenuti presenti nel suo indice per costruire sintesi personalizzate e multimodali, un passo che sposta il baricentro informativo dal sito al motore stesso.

Implicazioni per i brand e per la SEO

L’impatto sulle strategie di visibilità è tutt’altro che trascurabile.

In un contesto dove il motore risponde in modo autonomo, la posizione organica tradizionale perde parte del suo peso, mentre guadagnano importanza la presenza nei box AI e la citazione come fonte autorevole.

Gli studi di Search Engine Journal (2024) segnalano una riduzione media del CTR del 34,5% dopo l’introduzione delle AI Overview, con cali più evidenti nelle prime posizioni.

Il 75% delle fonti citate nelle AI Overview proviene dai primi 12 risultati organici, suggerendo che l’autorevolezza SEO di base resta una condizione necessaria per entrare nel nuovo formato.

Più che sostituire la SEO classica, l’AI la ricontestualizza: non basta più essere in cima alla SERP, bisogna anche essere riconoscibili, credibili e citabili dal sistema generativo.

Più impression, meno clic

Un effetto collaterale di questo scenario è ciò che alcuni analisti, tra cui Search Engine Journal, hanno definito “Great Decoupling”: un aumento delle impression in SERP, ma un calo netto dei clic reali.

In pratica, i siti continuano a essere visualizzati, ma gli utenti non hanno più bisogno di visitarli perché trovano le informazioni direttamente nei risultati.

Questa discrepanza rende più complessa l’interpretazione dei dati di traffico e costringe i marketer a considerare nuove metriche di performance, basate non solo sui clic ma anche sulla presenza visiva e reputazionale.

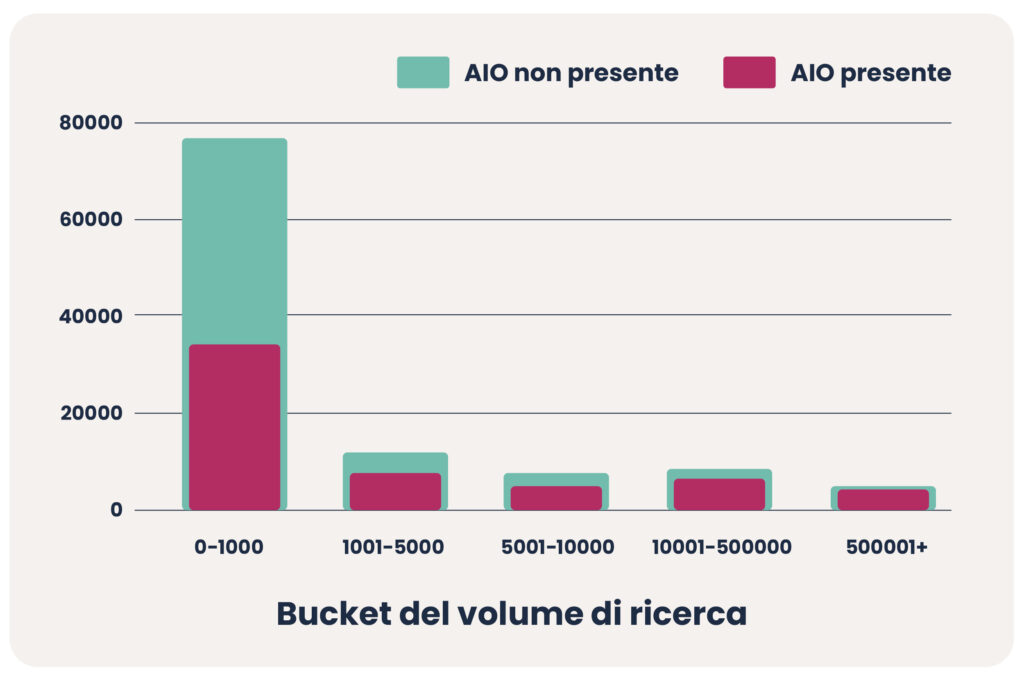

AI Overview per volume di ricerca

Un elemento cruciale emerso nell’analisi delle ricerche con intelligenza artificiale è il fattore volume di ricerca: le panoramiche AI tendono a comparire più spesso nelle query a basso traffico, presenti in circa il 55% delle ricerche con meno di 1.000 volumi mensili. Al crescere della popolarità delle keyword, invece, la loro presenza diminuisce progressivamente, raggiungendo i livelli più bassi nelle query con oltre 50.000 ricerche mensili. Questo trend suggerisce che l’IA viene impiegata con maggiore frequenza nelle ricerche più specifiche e di nicchia, dove l’utente mostra un’intenzione informativa più chiara, mentre sulle keyword ad alto volume,spesso più generiche e competitive, il contributo dell’AI risulta più marginale.

Frequenza delle AI Overview in base all’intento di ricerca

Le keyword a intento informazionale attivano una AI Overview nel 58,7% dei casi, segno che Google tende a offrire risposte sintetiche e di valore direttamente in SERP quando l’utente manifesta il desiderio di capire o approfondire un tema. In pratica, l’IA diventa un filtro che concentra il sapere diffuso del web in un’unica panoramica immediata. Al contrario, le query con intento commerciale generano queste risposte solo nel 19,4% dei casi, evidenziando come Google sia ancora più cauto quando l’obiettivo dell’utente è l’acquisto o la comparazione di prodotti. È un dato interessante, e in costante aumento, che lascia intuire come le AI Overview stiano evolvendo rapidamente verso un ruolo di supporto informativo, ma con un potenziale crescente anche per i brand che sapranno adattare i propri contenuti a questo nuovo formato.

Incidenza query long, mid tail e head keyword

Le AI Overview si attivano in modo predominante sulle query long-tail, che rappresentano circa il 73,6% dei casi. Seguono le mid-tail con un 17,6%, mentre le head keyword, più brevi e generiche, incidono solo per l’8,9%. Questo comportamento non è casuale: le ricerche long-tail riflettono esigenze più articolate e domande specifiche, spesso formulate in linguaggio naturale, come “come funziona…” o “qual è la differenza tra…”. Proprio questo livello di dettaglio offre all’intelligenza artificiale lo spazio ideale per elaborare risposte mirate, ricche di contesto e sfumature.

In altre parole, Google tende ad attivare le panoramiche AI dove può davvero “fare la differenza”: nelle query dove l’utente non cerca solo una risposta, ma una spiegazione, e dove la capacità dell’IA di sintetizzare fonti multiple diventa un vero valore aggiunto.

Query brand vs non-brand

Non tutte le ricerche sono colpite allo stesso modo. Le analisi di Agenda Digitale (2024) mostrano che le query generiche (es. “miglior smartphone 2025”, “come fare un tiramisù”) subiscono le perdite maggiori di CTR, perché sono le più facilmente assorbite dai box generativi. Al contrario, le query brandizzate (“iPhone 15 Apple”, “tiramisù GialloZafferano”) mostrano una maggiore resilienza e, in alcuni casi, addirittura un incremento di traffico.

La spiegazione è intuitiva: chi cerca un brand specifico ha già un’intenzione diretta e tende comunque a cliccare sul sito ufficiale.

Le AI Overview non cancellano dunque il valore del brand, ma lo accentuano.

Più un marchio è riconosciuto e cercato per nome, meno dipende dalle fluttuazioni dei sistemi generativi.

UGC e nuove fonti privilegiate

Un’altra tendenza osservata è la crescente presenza di contenuti generati dagli utenti (UGC), provenienti da piattaforme come Reddit, Quora o Wikipedia, all’interno delle panoramiche AI.

Google sembra considerare queste fonti come autentiche e conversazionali, in linea con il linguaggio naturale con cui gli utenti formulano le query.

Nei forum e nelle community, infatti, i contributi nascono per rispondere a domande reali, non per ottimizzare keyword, e questo tipo di contenuto risulta particolarmente coerente con le logiche dell’AI conversazionale.

Per i brand, ciò suggerisce una direzione chiara: stimolare interazioni reali e valorizzare le community può diventare un vantaggio competitivo.

Recensioni autentiche, thread di discussione e sezioni Q&A integrate nel proprio sito o canali social possono rappresentare nuovi segnali di valore, leggibili sia dagli utenti sia dagli algoritmi.

E-commerce e widget di prodotto

Nel settore e-commerce, l’effetto delle AI Overview si intreccia con l’espansione dei Product Widgets, che mostrano direttamente in SERP schede con immagini, prezzi, recensioni e disponibilità.

Le analisi di Search Engine Journal segnalano che i comparti più colpiti, in termini di perdita di traffico organico, stimata tra –15% e –50%, sono quelli legati a moda, beauty e arredamento.

Tuttavia, non si tratta necessariamente di una dinamica negativa: i brand che adottano dati strutturati (schema.org), feed aggiornati e recensioni autentiche possono apparire più frequentemente nei widget, trasformando la riduzione dei clic in visibilità contestuale e fiducia.

In altre parole, la nuova SEO non si misura più solo sul numero di visite, ma sulla capacità di essere presenti, anche indirettamente, nel percorso di ricerca dell’utente.

Essere citati, mostrati o integrati in un contesto AI può diventare tanto importante quanto essere cliccati.

EEAT e brand: la nuova SEO per AI

Negli ultimi anni, la qualità dei contenuti è diventata una delle variabili più decisive della SEO, e il principio EEAT (Esperienza, Competenza, Autorevolezza e Fiducia) ne rappresenta la sintesi più concreta.

Non è un fattore di ranking diretto, ma una bussola di qualità: un insieme di criteri che guida i sistemi di ricerca e i quality raters nella valutazione dell’affidabilità di un sito o di una pagina.

Come sottolinea Yuniarthe (2017), i controlli di qualità basati su intelligenza artificiale stanno diventando centrali per verificare che i contenuti rispettino gli standard EEAT, premiando chi dimostra competenza reale e valore informativo verificabile.

Questo approccio è stato rafforzato dal Helpful Content Update, che ha introdotto un filtro più severo contro i testi scritti “solo per Google”, ma poveri di utilità effettiva per l’utente.

Tuttavia, EEAT non è una formula rigida né una metrica automatica. Google non “misura” l’autorevolezza, ma la riconosce attraverso segnali coerenti:

- autori e fonti identificabili;

- riferimenti a esperienze dirette;

- linguaggio chiaro e trasparente;

- collegamenti a dati o casi concreti.

In questa logica, le tre domande proposte da Van Steenacker (2024) possono funzionare come test di qualità:

- Scriveresti questo contenuto anche se i motori di ricerca non esistessero?

- Il lettore lo troverebbe davvero utile e completo?

- L’autore o il brand mostrano prove tangibili di esperienza sul campo?

Se la risposta è “no” almeno una volta, probabilmente il contenuto non soddisfa pienamente i criteri EEAT.

Un segnale sempre più importante è la trasparenza autoriale Come sottolinea More (2025), con l’introduzione delle AI Overview e dei riepiloghi generativi, questa chiarezza è diventata essenziale. Google tende a privilegiare i contenuti che rispondono in meno di 100 parole a domande comuni, soprattutto se corredati da dati strutturati (FAQ, Q&A schema) e scritti con linguaggio diretto.

Per essere citati o riutilizzati da un sistema AI, i testi devono essere leggibili, sintetici e ben strutturati, con informazioni chiave in apertura, risposte concise e un uso corretto di dati strutturati (es. schema Q&A o Product).

Sul piano pratico, i contenuti che rispettano i principi EEAT tendono a ottenere:

- maggiore stabilità nei ranking, anche dopo gli aggiornamenti algoritmici;

- più citazioni nei risultati generativi e nei pannelli informativi;

- fiducia più alta da parte degli utenti, con benefici su CTR e conversioni.

Da notare anche il cambio di posizione di Google verso i contenuti generati da AI: non sono più penalizzati in sé, ma devono essere dichiarati, curati e realmente utili.

La discriminante, infatti, non è chi scrive il testo, ma quanto valore offre all’utente.

Dati tecnici, sicurezza e affidabilità infrastrutturale

In un panorama SEO sempre più dominato da modelli linguistici e sistemi generativi, può sembrare che la componente tecnica sia passata in secondo piano.

In realtà, secondo diversi studi (Yuniarthe, 2017; Kolèchkina e Orzhynsky, 2024), la solidità tecnica di un sito continua a essere una delle basi più affidabili per mantenere ranking e credibilità, anche in un contesto di ricerca governato dall’intelligenza artificiale.

Sicurezza e protocolli

Nel lavoro di Kolèchkina e Orzhynsky (2024) la sicurezza viene indicata come uno dei quattro pilastri fondanti della SEO adattiva.

Oltre all’aspetto etico della protezione dei dati, Google considera la sicurezza di navigazione un indicatore di fiducia:

- l’uso del protocollo HTTPS non è più un’opzione, ma una condizione minima per evitare che il sito venga segnalato come “non sicuro”;

- l’adozione di DNSSEC contribuisce a garantire l’integrità delle informazioni durante la risoluzione dei domini, riducendo il rischio di intercettazioni o man-in-the-middle attacks;

- l’impiego di certificati SSL aggiornati e header di sicurezza (come HSTS, CSP o X-Frame-Options) migliora la protezione contro attacchi cross-site.

In questo senso, la sicurezza non è solo un fattore tecnico, ma un segnale di qualità percepita: siti protetti e ben configurati trasmettono affidabilità sia agli utenti sia agli algoritmi.

Gestione dei bot e crawler AI

Un tema emergente è la gestione dei bot basati su intelligenza artificiale.

Con la crescita di crawler generativi, come ChatGPTBot o PerplexityBot, molti siti stanno rivedendo i propri file robots.txt per distinguere tra bot utili (che portano visibilità) e bot indesiderati (che possono saturare risorse o raccogliere contenuti senza consenso).

Non esiste ancora un consenso sul modo “giusto” di comportarsi: alcune aziende scelgono di bloccare questi accessi, altre preferiscono mantenerli per favorire la citazione nei risultati generativi.

Ciò che appare condiviso è la necessità di governare consapevolmente il traffico AI, monitorando frequenze di accesso e impatti sulle performance.

Ottimizzazione dei segnali tecnici

Le ricerche di Kolèchkina e Orzhynsky indicano che i sistemi adattivi più efficaci includono moduli dedicati a:

- monitoraggio del tempo di caricamento (core web vitals);

- analisi dei log di indicizzazione, per individuare pattern anomali nei passaggi dei crawler;

- validazione di sitemap XML e markup schema.org;

- rilevamento di duplicazioni o errori di canonizzazione che possono compromettere la coerenza semantica.

Queste attività, spesso automatizzate tramite API o script Python, permettono di intervenire rapidamente in caso di anomalie, riducendo i tempi di correzione e mantenendo il sito coerente con i requisiti tecnici di Google.

Accessibilità e interoperabilità

Un aspetto sempre più connesso alla qualità tecnica è l’accessibilità.

Google e gli organismi internazionali come W3C indicano da tempo che la web accessibility non è soltanto un requisito etico, ma anche un fattore di interpretabilità per i motori di ricerca.

Un sito accessibile, con struttura semantica corretta, etichette ARIA, testi alternativi, contrasto cromatico adeguato, risulta più leggibile anche per le AI che analizzano il codice e il layout.

L’interoperabilità, cioè la capacità di un sito di comunicare correttamente con diversi ambienti e dispositivi, è un’estensione naturale di questo principio.

Copyright, trasparenza e business model di Google

L’introduzione delle AI Overview ha sollevato un dibattito ampio e tuttora aperto: fino a che punto è legittimo che i motori di ricerca utilizzino contenuti prodotti da terzi per generare risposte dirette all’interno della SERP?

Il tema intreccia tre dimensioni, etica, giuridica e commerciale, e riflette un equilibrio ancora da definire tra diritto d’autore, trasparenza delle fonti e sostenibilità dell’ecosistema informativo.

Il riuso dei contenuti e il principio di “fair use”

Le AI Overview, per costruire risposte sintetiche, attingono al vasto indice di pagine che Google già utilizza per la ricerca tradizionale.

Tecnicamente, si tratta di un’estensione del suo funzionamento: i contenuti non vengono copiati integralmente, ma rielaborati in forma generativa.

Tuttavia, la differenza tra “sintesi” e “riuso” non è sempre chiara.

Alcuni editori e associazioni di categoria hanno sollevato il timore che questa pratica possa tradursi in una forma di “cannibalizzazione dei contenuti”: le informazioni vengono mostrate direttamente in SERP, riducendo il traffico verso i siti originari.

Da qui nasce il dubbio se l’uso rientri nel fair use (utilizzo legittimo a fini informativi) o se possa configurare una violazione del diritto d’autore.

Attualmente non esiste una posizione univoca.

Negli Stati Uniti, il fair use viene interpretato in modo relativamente ampio, ma in Europa il Digital Services Act e le direttive sul copyright tendono a richiedere maggiore trasparenza e consenso nell’utilizzo dei materiali creativi.

In questo quadro, il ruolo dei meta tag come noai o nocache, introdotti per limitare l’accesso dei bot AI ai contenuti, rappresenta una prima forma di autodifesa editoriale, ma la loro adozione non è ancora standardizzata.

Trasparenza delle fonti e tracciabilità

Un’altra questione riguarda la trasparenza delle fonti.

Nelle AI Overview, Google indica a volte le fonti utilizzate, ma non sempre in modo chiaro o completo.

Ciò crea un vuoto informativo: l’utente può ottenere una risposta corretta ma senza sapere da dove provenga.

Diversi analisti (tra cui Search Engine Journal e BrightEdge, 2024) sottolineano che, se il motore di ricerca diventa anche il principale editore sintetico, allora la tracciabilità delle informazioni dovrebbe essere garantita almeno quanto l’accuratezza.

In parallelo, piattaforme emergenti come Perplexity AI o You.com stanno sperimentando approcci più trasparenti, dove ogni risposta include riferimenti diretti alle fonti.

Non è ancora chiaro se Google seguirà la stessa direzione, ma la pressione verso una maggiore visibilità delle fonti appare in crescita.

Impatto sul modello di business

Il terzo nodo del dibattito riguarda il modello economico della ricerca.

Se gli utenti trovano ciò che cercano senza uscire dalla SERP, diminuiscono i clic verso i siti editoriali, ma aumenta la permanenza all’interno dell’ecosistema Google, dove si concentrano anche le attività pubblicitarie.

In prospettiva, questo potrebbe ridurre la sostenibilità dei modelli basati su ricavi da traffico organico (come blog, magazine e portali di settore), rafforzando al contempo la centralità della piattaforma.

Alcuni studiosi (Avantgarde, 2024) parlano di una possibile “riedizione della disintermediazione”: Google, nato come ponte verso i contenuti, diventa sempre più punto d’arrivo, riassumendo e filtrando ciò che prima distribuiva.

Non è detto che questo scenario sia negativo per tutti: per i brand riconosciuti, essere citati all’interno di un AI Overview può equivalere a una nuova forma di visibilità, anche senza clic diretti.

Ma per i siti che basano il proprio modello economico sull’advertising, la riduzione del traffico può rappresentare una criticità concreta.

Verso un equilibrio ancora da definire

Al momento, il sistema si trova in una fase sperimentale.

Non esistono linee guida definitive né standard condivisi tra editori, motori e legislatori.

L’impressione generale è che si stia cercando un compromesso tra innovazione tecnologica e tutela dei diritti, dove i principi di attribuzione, trasparenza e tracciabilità avranno un peso sempre maggiore.

Come osserva More (2025), l’obiettivo realistico per i prossimi anni non sarà impedire alle AI di utilizzare contenuti, ma definire criteri di uso responsabile e meccanismi di riconoscimento del contributo originario.

Finché questo equilibrio non sarà codificato, la relazione tra creatori di contenuti e motori di ricerca rimarrà un territorio in movimento, dove la collaborazione, più che la contrapposizione, potrebbe risultare la chiave per costruire un nuovo modello sostenibile di ricerca e distribuzione dell’informazione.

Il futuro dei motori di ricerca con intelligenza artificiale

La direzione verso cui si stanno muovendo i motori di ricerca non è più quella del semplice “elenco di risultati”, ma quella di una piattaforma cognitiva che comprende, sintetizza e risponde.

L’intelligenza artificiale non sostituisce la ricerca, ma ne cambia la grammatica: le query diventano conversazioni, le SERP diventano contesti informativi, e la posizione organica si trasforma in visibilità contestuale.

L’avvento della modalità AI e delle ricerche multimodali

Secondo quanto emerso dal Webinar di Contesotto (2024), la cosiddetta AI Mode, già attiva anche in Italia, ma più matura negli Stati Uniti in lingua inglese, rappresenta un cambio di paradigma.

Google, attraverso Gemini, genera risposte dinamiche e personalizzate, corredate da immagini, fonti e domande di approfondimento (i follow-up).

Accanto a essa, si inserisce la funzione Deep Search, che fornisce veri e propri mini-report tematici con grafici, paragrafi e fonti selezionate.

Si tratta di una transizione verso una ricerca multimodale, in cui testo, voce e immagini convivono in modo sempre più integrato. Strumenti come Lens, permettono già di interrogare la realtà visiva, inquadrando un oggetto, un paesaggio o una scena, e ottenere risposte generate in tempo reale.

La distinzione tra ricerca visiva, vocale e testuale si sta così attenuando, a favore di un’esperienza fluida e “ibrida”.

SEO e UX diventano inseparabili

In questo nuovo scenario, la SEO non è più solo ottimizzazione per i motori, ma diventa parte integrante dell’esperienza utente (UX).

Come ricorda More (2025), l’INP (Interaction to Next Paint) ha ormai sostituito il FID nei Core Web Vitals, segno che Google valuta sempre più la qualità dell’interazione reale, non solo i tempi di caricamento.

Siti veloci, chiari e intuitivi mantengono un vantaggio, non perché “piacciono all’algoritmo”, ma perché riflettono i comportamenti di ricerca e navigazione dei nuovi utenti AI-driven.

L’ottimizzazione, in questo senso, si sposta da una logica reattiva a una logica adattiva: non si tratta più di rispondere agli aggiornamenti, ma di anticiparli attraverso sistemi che imparano, analizzano e si correggono autonomamente.

È l’approccio che Kolèchkina e Orzhynsky (2024) definiscono adaptive SEO system: un ecosistema che monitora continuamente traffico, CTR, segnali social e tempi di permanenza per aggiornare automaticamente strategie e contenuti.

Dal contenuto all’intento, e dall’intento al contesto

La SEO basata su parole chiave lascia progressivamente spazio a quella basata sull’intento e, più recentemente, sul contesto.

Come già suggeriva Yuniarthe (2017), algoritmi come RankBrain e BERT non analizzano più solo le parole, ma le relazioni semantiche e il comportamento dell’utente.

Oggi, con i modelli generativi, questa capacità si amplifica: l’AI non si limita a interpretare, ma ricompone il significato, integrando fattori come località, preferenze, cronologia e modalità di input (voce, testo, immagine).

Per i contenuti, ciò implica un cambiamento metodologico.

Non basta più “coprire una keyword”, ma fornire una risposta chiara, completa e rilevante a una domanda reale.

Come osserva More (2025), le risposte sintetiche e ben strutturate, entro 100 parole, con uso di dati strutturati e schema Q&A, tendono a essere privilegiate dai sistemi AI, perché leggibili e riutilizzabili nei riepiloghi generativi.

Verso una “Search Engine Everywhere

La traiettoria più interessante, forse, è quella che alcuni analisti sintetizzano come Search Engine Everywhere.

Non si cerca più solo su Google, ma anche dentro ChatGPT, in Perplexity, su TikTok, nei chatbot di assistenza o nei marketplace.

Ogni piattaforma diventa un motore di scoperta, e la SEO si trasforma in strategia di presenza semantica diffusa.

In questo contesto, le menzioni dell’AI, cioè le volte in cui un brand viene citato nei sistemi generativi, diventano una nuova metrica di successo.

Come suggeriscono gli studi di Search Engine Journal e SparkToro, monitorare tali menzioni, correggere i “citation gaps” e ottimizzare la struttura dei contenuti per la leggibilità AI sarà sempre più parte integrante del lavoro SEO.

Una SEO più ibrida, meno prevedibile

Il futuro della SEO, a giudicare dalle tendenze analizzate, appare ibrido e adattivo.

Gli algoritmi continueranno a evolversi, ma la direzione di fondo sembra chiara:

- centralità dell’intento e dell’esperienza utente;

- equilibrio tra automazione e supervisione umana;

- integrazione crescente tra AI, contenuti, sicurezza e brand identity.

Come osservava Yuniarthe già nel 2017, “l’AI non sostituisce la SEO, ma ne diventa il linguaggio naturale”.

Oggi quella previsione sembra concretizzarsi: i motori di ricerca non sono più meri indicizzatori, ma interpreti e narratori dell’informazione digitale.

In un contesto così dinamico, la capacità di adattarsi e comprendere il cambiamento diventa forse la vera forma di ottimizzazione.

Fonti

-

Rathnayaka, G., Gonawala, S., Dananjana, P., Arambawela, J., Senarathne, A., & Siriwardena, D. (2024, December). A BERT-Based Approach to Keyword Search for Digital Evidence Analysis. In 2024 6th International Conference on Advancements in Computing (ICAC). IEEE.

-

AI Overviews Study: Inside Google’s New Search Reality. Report DEMANDSPHERE 2025.

Articolo Completo -

Kolyechkina, L. M., & Orzhynskyi, O. O. (2024). Analisi di un sistema SEO adattivo che tiene conto della dinamica degli algoritmi dei motori di ricerca e degli elementi di protezione.

-

Testata di Settore

-

Yuniarthe, Y. (settembre 2017). Applicazione dell’intelligenza artificiale (IA) nell’ottimizzazione dei motori di ricerca (SEO). Conferenza internazionale su Soft Computing, Sistemi intelligenti e tecnologie dell’informazione (ICSIIT) (pp. 96–101).

-

Digital Climax Helpful content & EEAT gids: Praktische tip, Bewezen technieken. Jouw partner voor betere rankings en meer verkeer. Axl Van Steenacker.

-

Колєчкіна, Л. М., & Оржинський, О. О. (2024). Аналіз адаптивної SEO-системи з урахуванням динаміки алгоритмів пошукових систем та елементи захисту. arXiv preprint arXiv:2408.16119. Articolo Completo